Pour rester compétitives, les entreprises doivent désormais intégrer l'intelligence artificielle (IA) dans leur stratégie. Malgré ses avantages certains, l'IA reste complexe à mettre en œuvre pour beaucoup d'entreprises. Face aux défis de l'adoption de l'IA, Nvidia a lancé les NIMs (Neural Inference Models), des microservices d'inférence neuronale conçus pour démocratiser l'accès à des modèles d'IA personnalisés et simplifier leur déploiement.

Intégrables dans des infrastructures existantes, ces modèles offrent une grande flexibilité, permettant aux entreprises de concevoir des IA sur mesure sans avoir à partir de zéro.

La vision de l'IA de Nvidia

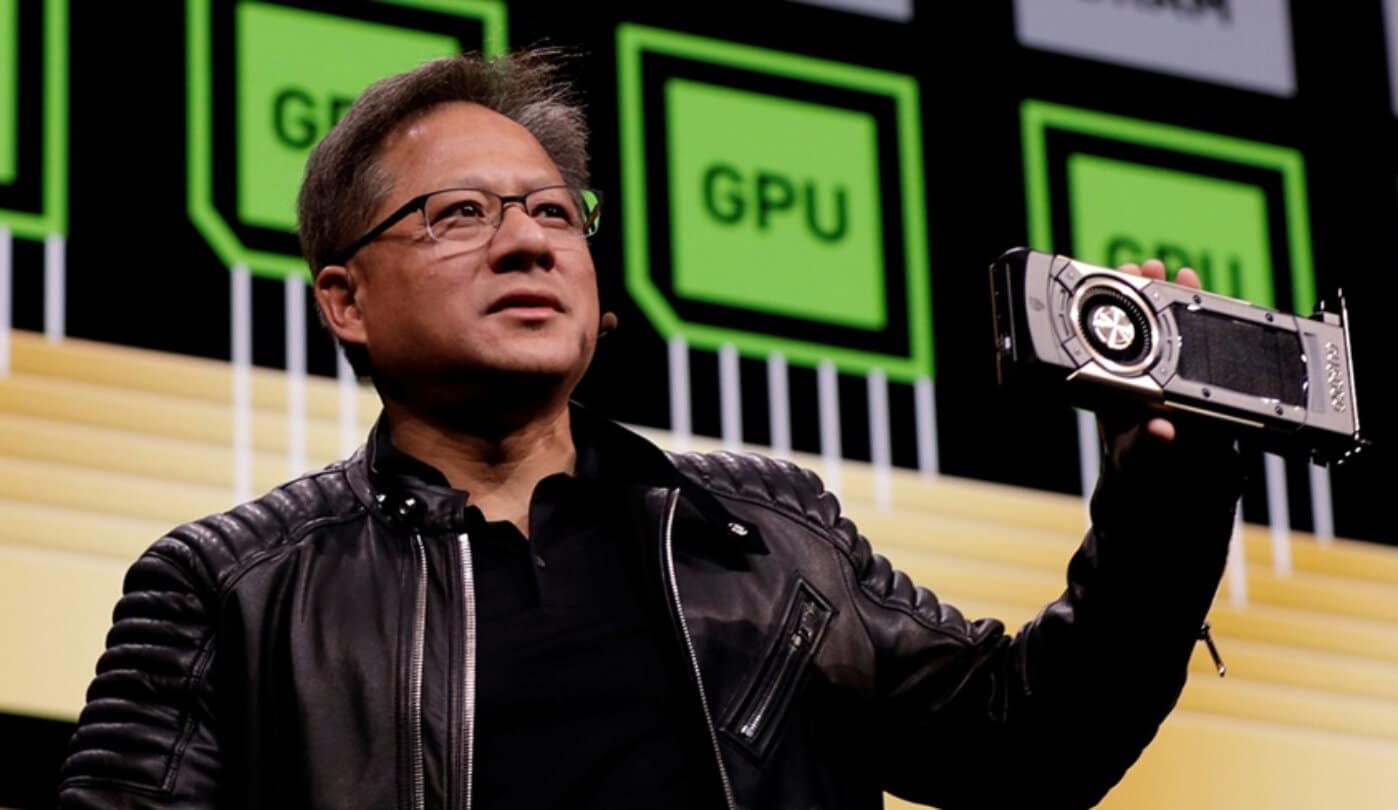

Lors de la GPU Technology Conference 2024 (GTC 2024), Jensen Huang, CEO de Nvidia, a souligné l'évolution de Nvidia et de son approche du marché des data centers. Dès 2016, Jensen Huang affirmait l'ambition de conquérir ce secteur, et huit ans plus tard, avec l'appétit de l'IA en puissance de calcul, son pari est pleinement réussi.

"Nvidia ne construit pas de puces, nous construisons des data centers", a-t-il déclaré, soulignant le rôle central de Nvidia dans le secteur, où la croissance des data centers est désormais un vecteur économique. En 2023, ce marché pesait déjà 250 milliards de dollars et continue de croître de près de 25 % par an, selon ses propos lors de la GTC 2024.

Jensen Huang présente l'ère de l'IA comme une "révolution industrielle". Une révolution nécessitant des "AI Factories", des data centers conçus pour produire des tokens à partir de données, comparables à des centrales électriques. À travers l'image d'usines, Jensen Huang souhaite changer la manière dont les entreprises perçoivent les data centers avec l'IA : des usines génératrices de profit.

Au centre de cette vision de l'IA se trouve le principe de "fonderie d’IA (AI Foundry)" chez Nvidia, un service qui permet aux entreprises de concevoir des modèles d’IA générative sur mesure, adaptés à leurs besoins spécifiques sans se reposer sur les modèles génériques hébergés par des acteurs du cloud comme Amazon, Microsoft, Google, etc. Dans cette vision de fonderies d'IA, les NIMs (Neural Inference Models) sont des pièces maîtresses.

NVIDIA NIMs (Neural Inference Models)

Les NIMs sont des microservices conteneurisés conçus pour faciliter le déploiement de modèles d'IA générative. Chaque microservice inclut un modèle d'IA, un environnement d'exécution et un moteur d'inférence dans un seul package, ce qui simplifie son utilisation.

Les NIMs s'intègrent aisément aux infrastructures existantes en utilisant des technologies standard telles que Kubernetes, sans nécessiter de nouveaux outils d'orchestration. Les entreprises peuvent exploiter des modèles open source provenant de leaders comme Google, Meta ou Hugging Face, ainsi que des modèles propriétaires de Nvidia, tels que Nemotron.

Une manière simple et rapide de mise en place de solutions d'IA générative.

Prise en main des NIMs

Pour se familiariser avec les NIMs, il est possible de rejoindre le programme développeur sur le site NVIDIA AI, où de nombreuses ressources sont disponibles. L'inscription est gratuite et donne accès, notamment, à NVIDIA NIM.

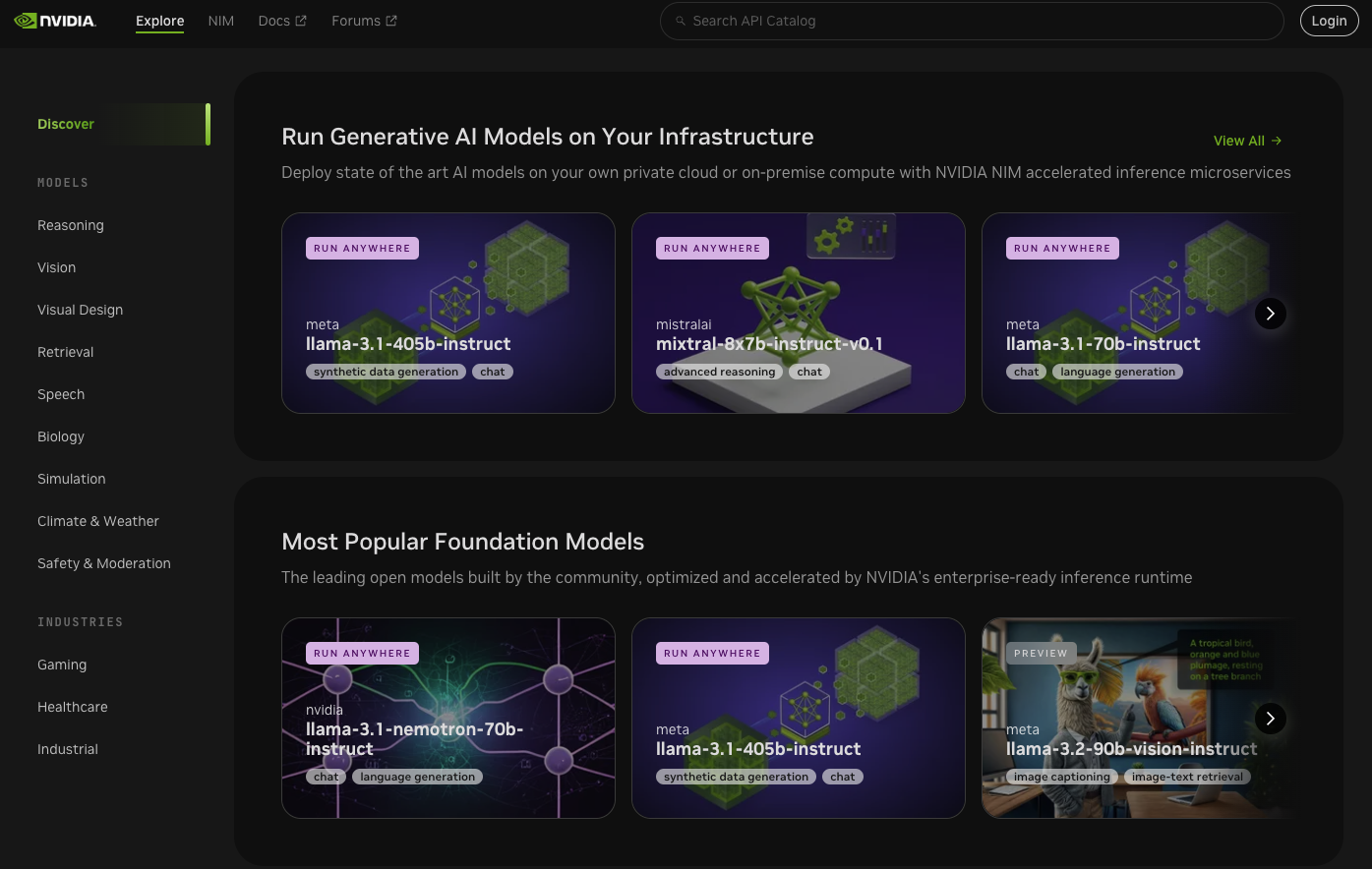

A travers le dashboard accessible sur https://build.nvidia.com/, NVIDIA propose différents services et modèles d'IA comme :

- Développer des avatars capables d'interagir avec un service client, d'interagir avec des joueurs dans un jeu vidéo, ou de servir de méthode ludique pour l'apprentissage.

- Utiliser des modèles spécialisés, tels que ceux pour la prévision météorologique ou pour le développement de molécules en pharmacologie, par exemple.

- Implémenter de manière simplifiée un RAG (Retrieval-Augmented Generation) pour interagir avec des documents, tels que des PDF, à l'aide de modèles de LLMs.

En sélectionnant un modèle LLM dans le menu "Reasoning", on peut interagir avec des modèles préentraînés tels que llama-3.2, Nemotron ou mistralai.

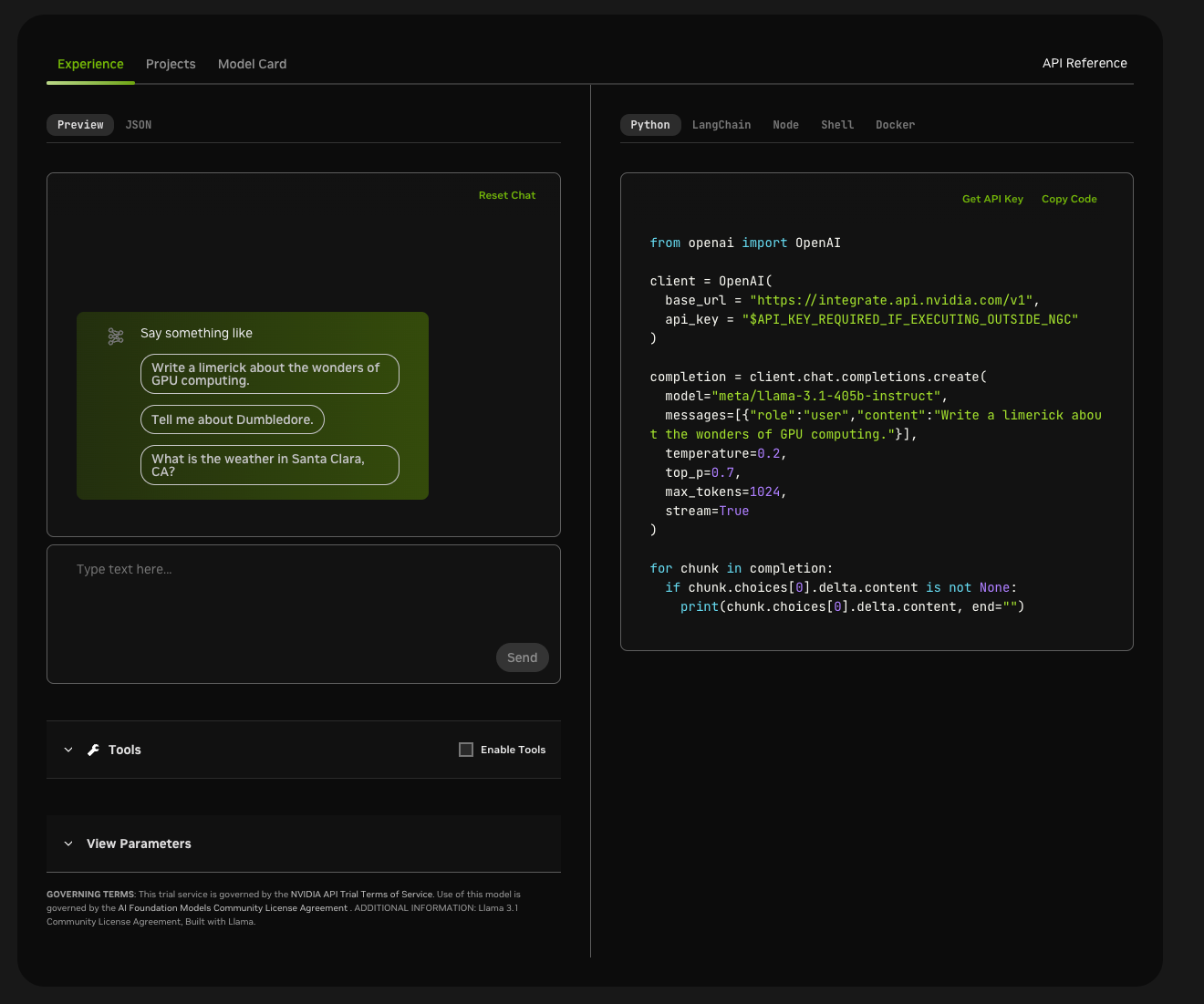

Sur la console il est possible :

- D'interagir avec le modèle en ligne, de customiser les paramètres du modèle (comme la température ou le top p, par exemple).

- D'utiliser des outils prédéfinis.

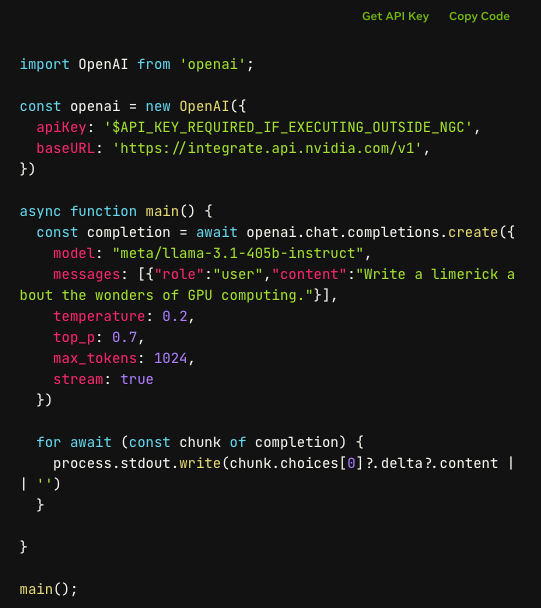

- Ou bien de manipuler le modèle à l'aide de code Python, en utilisant la bibliothèque LangChain (également possible en JS), Shell, ou Node.js grâce à l'API d'OpenAI, largement répandue aujourd'hui.

En cliquant sur "Build with this NIM" en haut de la console d'un modèle, il est possible d'obtenir une API KEY qui permet d'accéder à :

- 1000 appels API avec un email personnel ou 5000 avec un email professionnel.

- Mais aussi de déployer sa propre solution NIM sur son infrastructure.

L'intégration d'un microservice NIM dans un conteneur Docker est l'aspect le plus intéressant de cette console. Pour ce faire, il suffit de récupérer le modèle sélectionné, de le déployer dans un conteneur Docker, puis d'interagir avec lui via HTTP.

Guide video d'intégration d'un microservice NVIDIA NIM

Conclusion

Nvidia apporte ses armes à la révolution industrielle qu'est l'IA avec ses NIMs, rendant l'IA générative accessible, flexible et performante pour les entreprises. À travers la combinaison de microservices prêts à l'emploi, une intégration via des technologies standards comme Kubernetes, et des outils de personnalisation avancés, Nvidia propose une solution non négligeable à l'optimisation du processus d'intégration de l'IA dans les entreprises.

Avec sa vision de transformer les data centers en "AI Factories", Nvidia consolide sa position en tant que leader dans l'écosystème de l'IA.