Les LLMs et des logiciels comme chatGPT ont eu l’effet d’un coup de tonnerre dans l’environnement tech. Cependant, ces modèles génératifs impressionnants souffrent tous d’une même limitation. Une incapacité à interagir avec l’environnement extérieur.

Cela fait plus de deux ans que chatGPT est sorti, et à l’heure actuelle, il n’existe toujours pas de LLM grand public pouvant envoyer un mail, réserver un billet de train, payer une amende…

Mais, contrairement à ce que l’on pourrait penser, il ne s’agit pas d’une limitation d’intelligence mais d’un problème d’interface.

En effet, si ces modèles et leurs implémentations sous forme de chatbots ont une bonne capacité de compréhension de l’intention de l’utilisateur et de compilation de textes pour faire des suggestions appropriées, le passage à l’action est bien plus compliqué.

Agents et personas

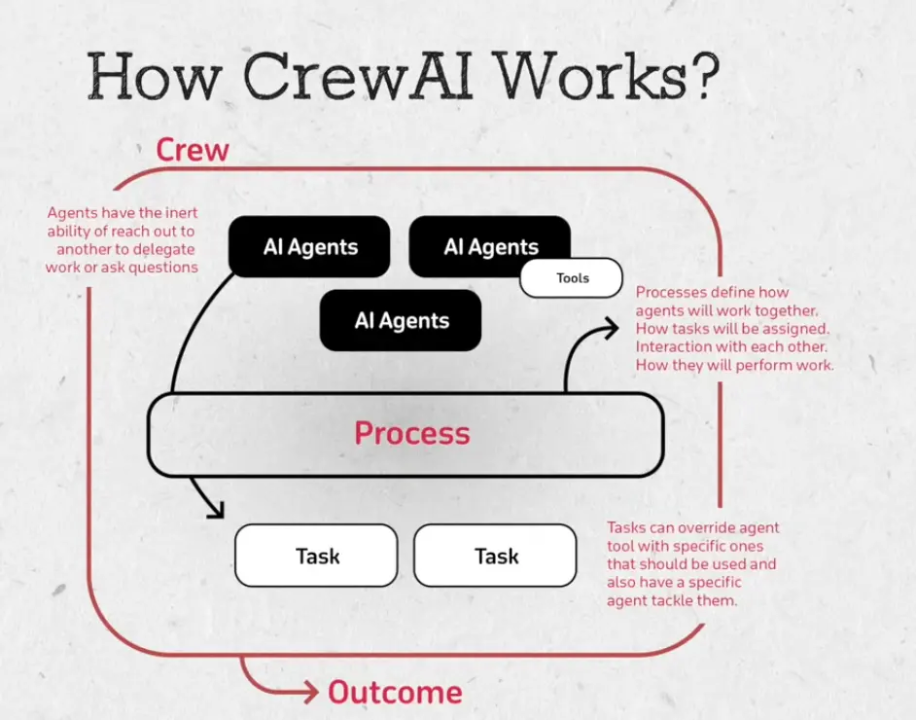

Une première tentative était l’utilisation d’agents, en créant des personas spécialisés qui communiquent entre eux à partir d’une requête utilisateur et effectuent un traitement ad hoc du texte jusqu’à répondre à la requête. Par exemple ‘crew ai’ qui propose une équipe de LLMs qui génèrent des posts instagram pour leurs clients.

- Un agent va récupérer de l’information sur le web à propos de l’entreprise et des ses concurrents.

- Un agent va compiler ces informations.

- Un agent va générer des prompts pour midjourney à partir de ces informations et également générer des descriptions liées à ces images.

Mais, si cette approche est intéressante, elle demande encore beaucoup d’interventions humaines et consomme énormément des tokens dans les différents appels APIs. Et surtout, bien moins trivial qu’il n’y paraît, les agents issus de LLMs sont limités dans leurs actions par leur incapacité à cliquer sur des boutons…

Cliquer sur des boutons

Cette tâche pourtant facile pour un humain est actuellement mission impossible pour ces modèles générateurs de texte.

Par exemple, là où réserver un billet de train pour un humain consiste à cliquer sur le trajet souhaité et entrer ses coordonnées avant de cliquer pour finaliser la transaction, les LLMs incapables de gérer une souris ou de comprendre un screenshot sont encore obligés de passer par des appels APIs.

Une réponse à appel APIs est un format de données structurées. Un LLM peut donc l’interpréter et comprendre la réponse à la requête et communiquer avec le service. Bien que cela puisse paraître une réponse adaptée, de nombreux services ne disposent pas encore d'une API. D'autres, dont la valeur repose sur leur contenu (comme Reddit), se protègent désormais des modèles génératifs en coupant leurs API ou en augmentant considérablement leurs tarifs.

Mais, même sans tenir compte de cette limitation, interagir avec une API implique la création d’un compte développeur sur chaque plateforme, la gestion des accès et aussi de développer un code adapté à chacune. Sachant qu’elle peut être soumise à des changements qui impliquent une refacto totale ou partielle du code.

Ce code n’étant pas possible à fournir ou maintenir de manière efficace, il faut donc apprendre aux LLMs à interagir avec le web comme le feraient des humains.

Entre LLM et humain

Pour cela, un projet consistait à fournir le code source de la page au modèle et de lui indiquer le nom du bouton sur lequel cliquer, mais les résultats sont mitigés.

Une autre idée est de tirer profit de l’aspect multimodel de ces systèmes et de tirer parti de la capacité des modèles de vision des images de ces systèmes.

Mais, cela reste très laborieux. En effet, ces modèles de classification d’images ou de générations de textes ne sont pas conçus pour effectuer des actions, cela pousse donc ces systèmes au bout de leurs capacités avec des résultats parfois incongrus.

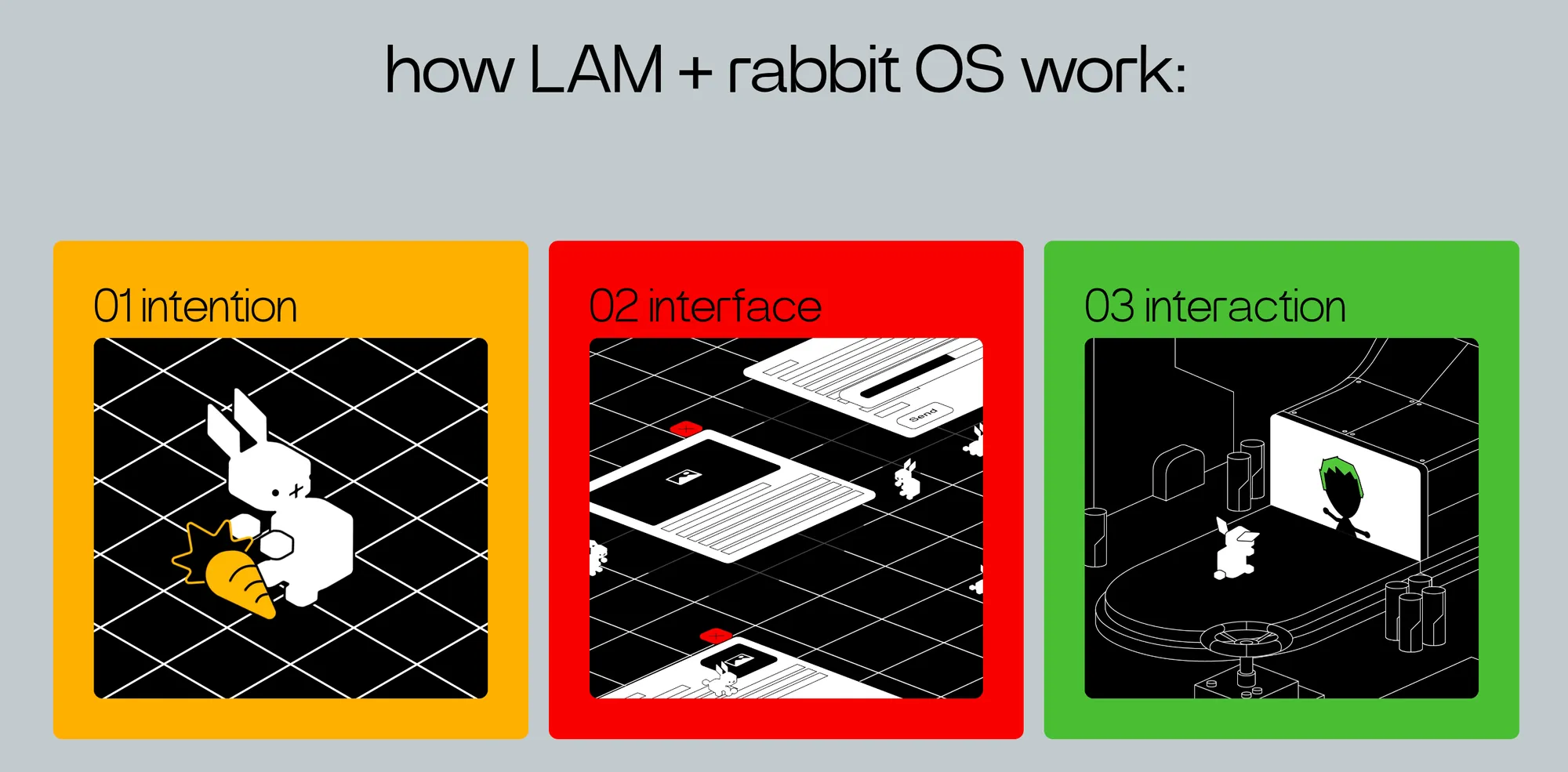

Enfin, l’approche qui semble la plus prometteuse aujourd’hui est le Large Action Model. Montrer une fois l’action au model et lui apprendre comment la reproduire. Où cliquer, où écrire… Le modèle saura alors comment généraliser les actions et par exemple répondre aux pop ups d’accords de cookies, de captchas… et ainsi automatiser des actions.

Toutes ces approches sont intéressantes, mais demandent encore beaucoup de recherches et d’investissements avant que les LLMs aient un véritable impact sur le monde réel par la réalisation d’actions concrètes en dehors du silo de leurs infrastructures et de ce qui est accessible via une API.

Qui aurait cru qu’en 2024 un bouton submit ou un captcha anti-robots sauverait l’humanité du soulèvement des machines ?

Si vous souhaitez en apprendre plus sur les LLMs, comment créer vos propres LLMs, ou encore tout savoir sur l'architecture RAG, découvrez nos articles sur le sujet 👇

![[KubeCon 25] Comment sécuriser vos conteneurs Kubernetes avec Falco et Talon ?](/content/images/size/w1304/2025/04/falco2.png)