Lors de Cloud Next'24, nous avons assisté à la conférence « Unlock High Performance and AI Workloads On-Premises with Distributed Cloud », animée par Raja Jadeja, Group Product Manager chez Google Cloud, et Valentin Hamburger, Senior Product Manager chez Google Cloud.

La modernisation des charges de travail hautes performances et d’IA, qui doivent rester sur site, peut s’avérer difficile. Apprenez auprès des experts comment optimiser votre cloud hybride en déployant Google Kubernetes Engine (GKE) sur Google Distributed Cloud. Offrez une expérience de développement cohérente sur site et dans le cloud, et préservez votre retour sur investissement en tirant parti de vos investissements matériels existants. Découvrez comment optimiser les cycles de mise à niveau, rationaliser les opérations et donner à vos développeurs les mêmes outils cloud qu'ils utilisent avec GKE.

Voilà la promesse de cette conférence.

Cette petite session n’a pas été suivie par beaucoup de monde, car elle a été programmée à la fin de Next’ 24, lorsque tout le monde était déjà bien fatigué. De plus, elle était située dans l’Expo Hall, i.e. au milieu d’un brouhaha constant, rendant tout enregistrement impossible. Nous allons donc essayer de vous retranscrire ce qu’il s’y est dit.

Qu’est-ce que le Distributed Cloud ?

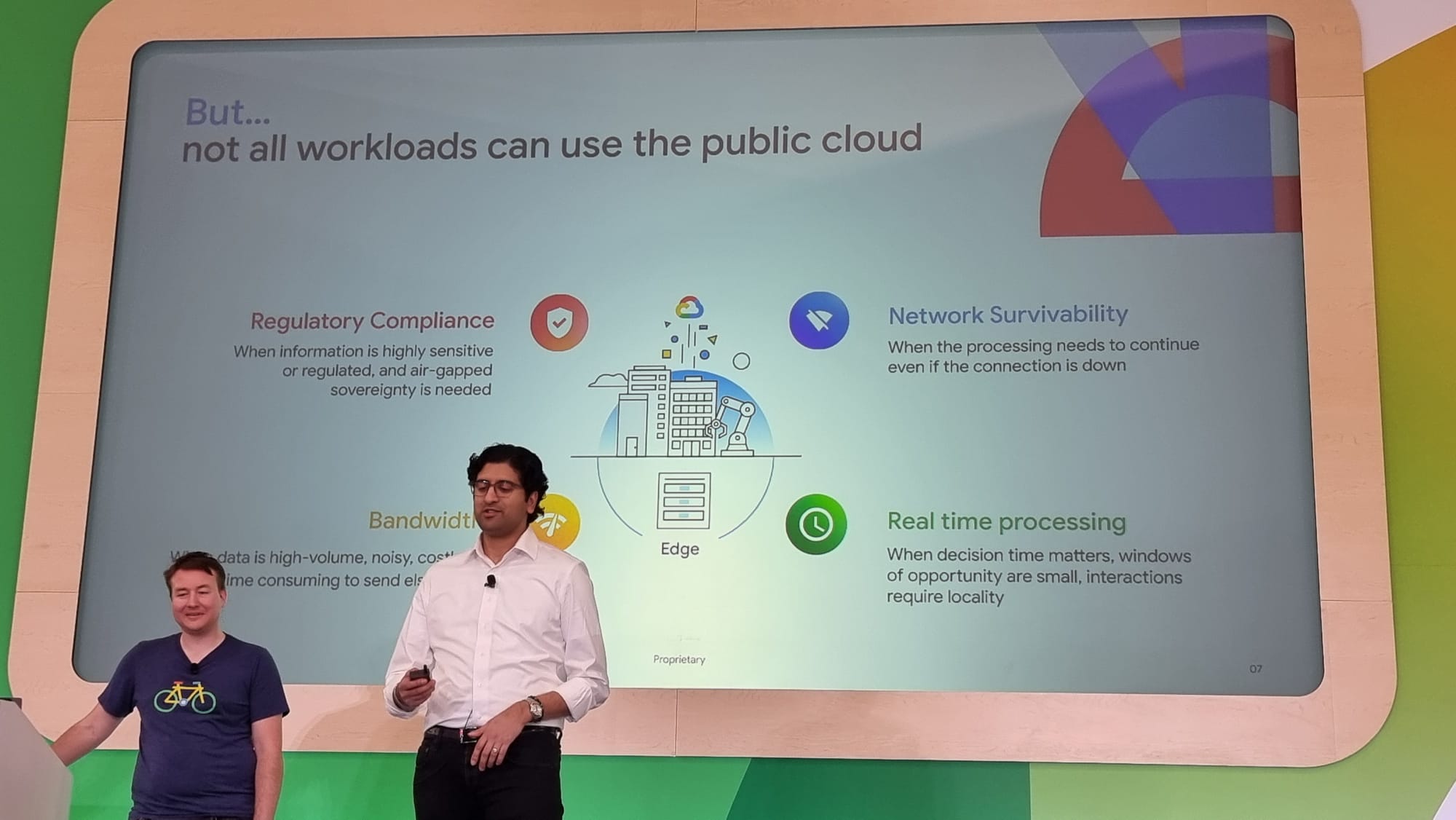

Google Cloud offre de multiples avantages pour déployer des applications, nous espérons ne pas avoir à vous en convaincre, mais malheureusement, toutes les applications ne sont pas adaptées à être déployées dans le Cloud.

Que ce soit pour des contraintes techniques, de coûts, ou plus généralement des contraintes légales, il existe de multiples raisons pour lesquelles il serait préférable de laisser certaines applications sur des datacenters on premises.

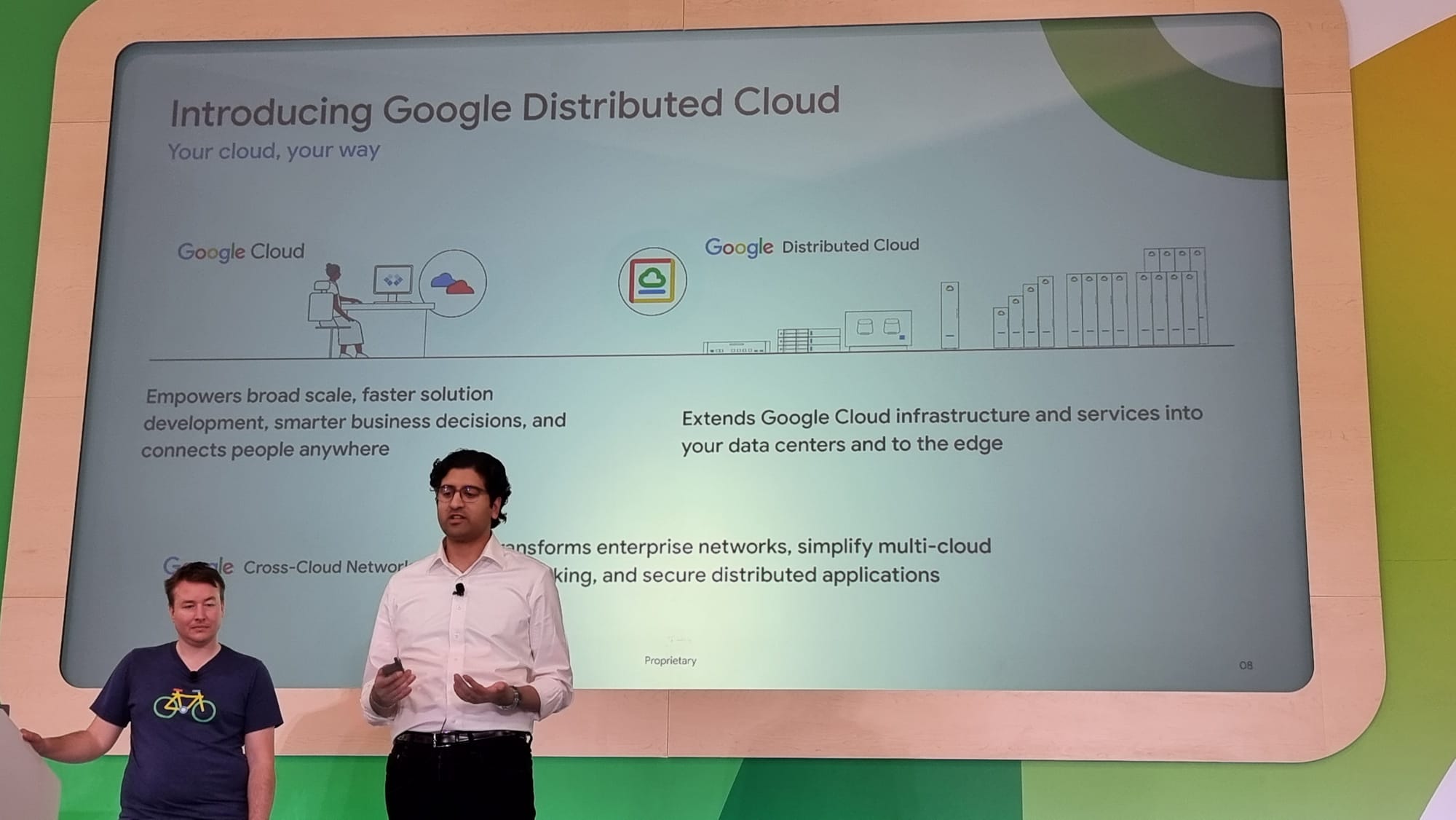

Qu’importe! Google Cloud dispose de plusieurs solutions techniques, sous le terme “Distributed Cloud”, pour amener ses services jusqu’au cœur de vos datacenters, ce que l’on a notamment vu dans un article précédent (ici) avec les solutions Cross Cloud Network.

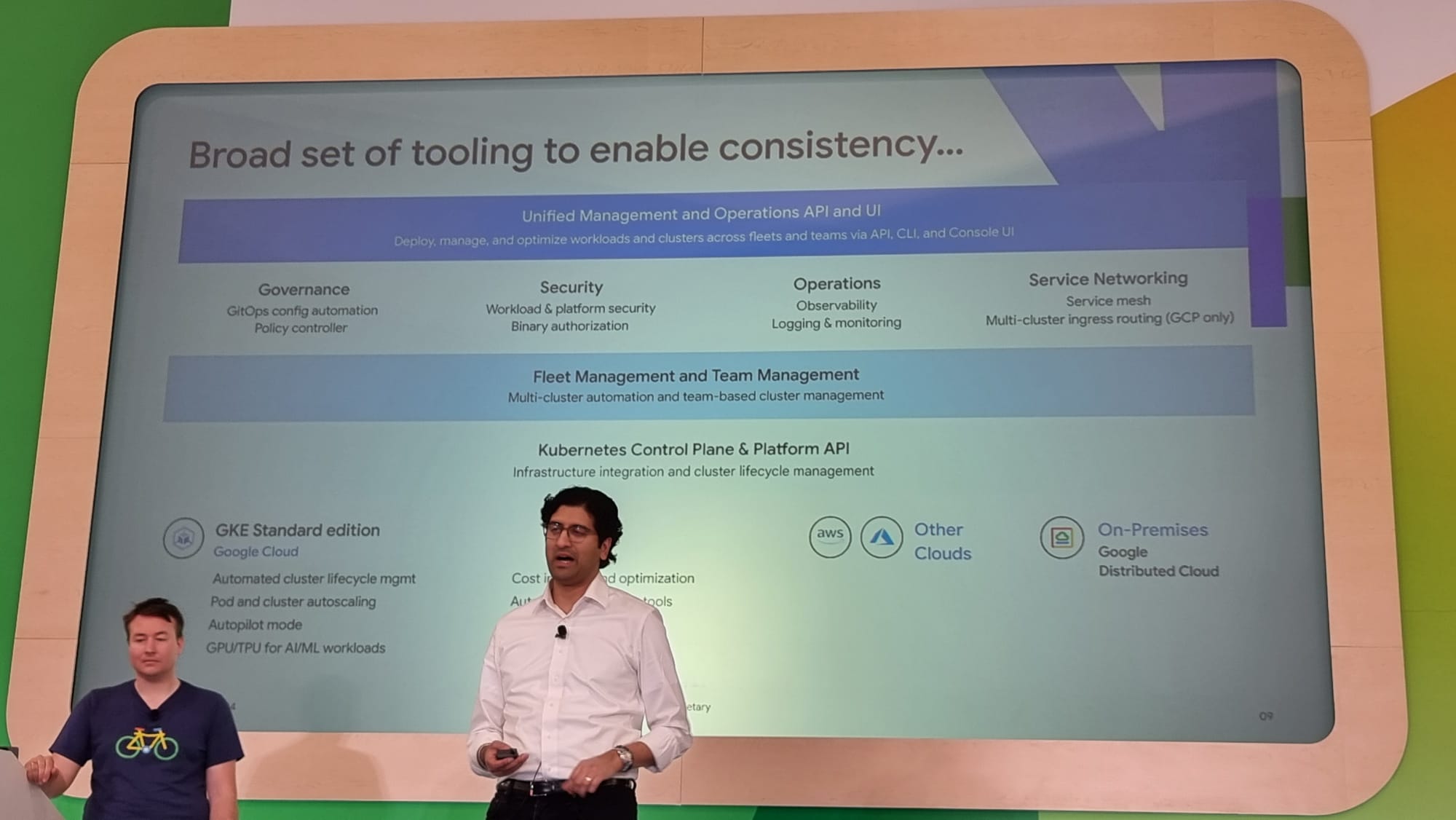

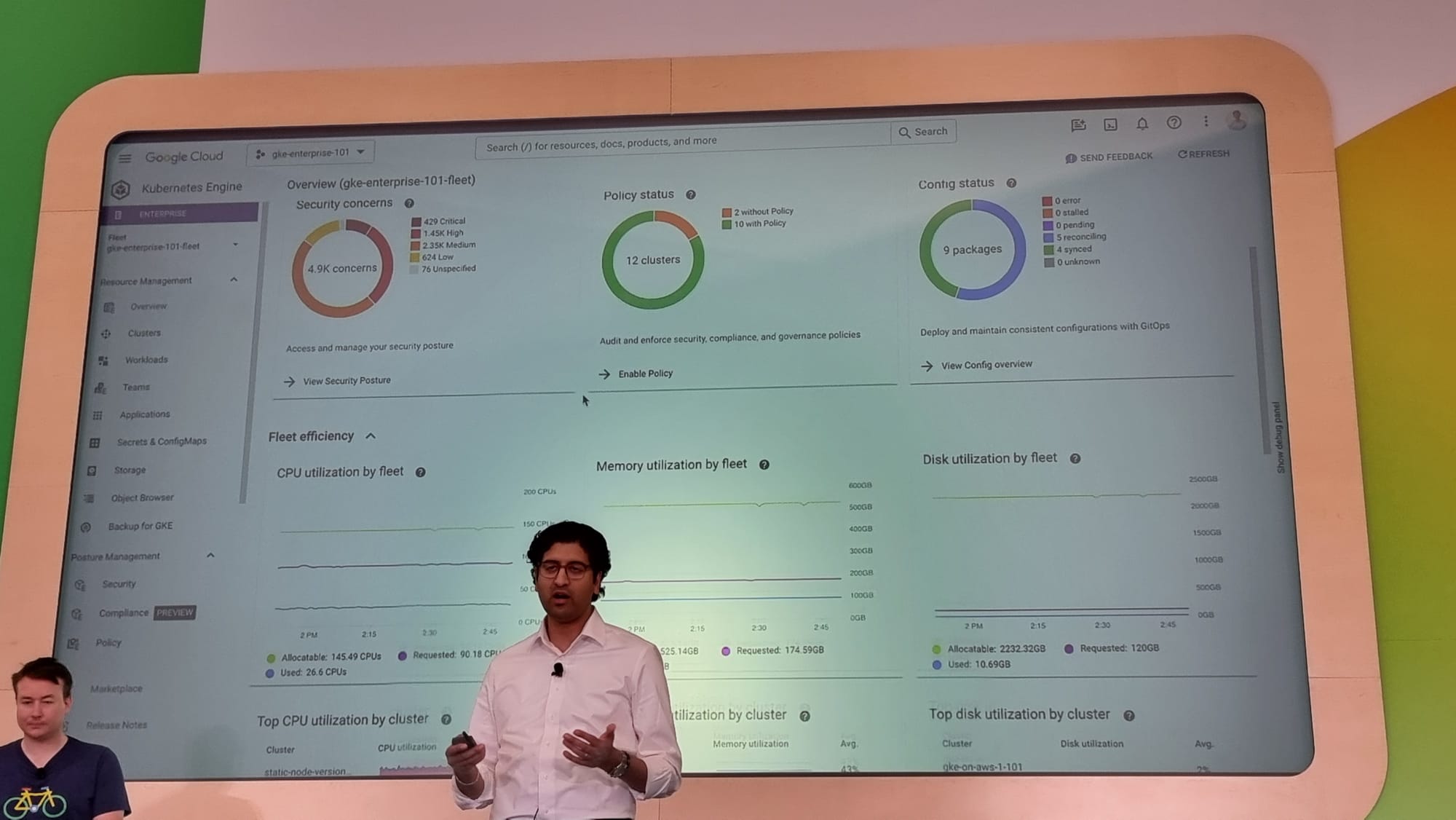

Dans la continuité, une autre possibilité offerte par Google Cloud est l’utilisation de GKE on prem, permettant d’installer des clusters GKE dans vos datacenters. Ce qui vous permet de disposer de clusters kubernetes managés chez vous, sur lesquels vos applications sont déployées et gérées sur Google Cloud, via le système de fleets, dans GKE Entreprise.

L’avantage immédiat est donc la simplicité de l’administration de vos clusters, mais pas seulement : GKE on prem dispose de multiples features techniques par rapport à une installation de Kubernetes classique.

Les nouvelles features de GKE on prem

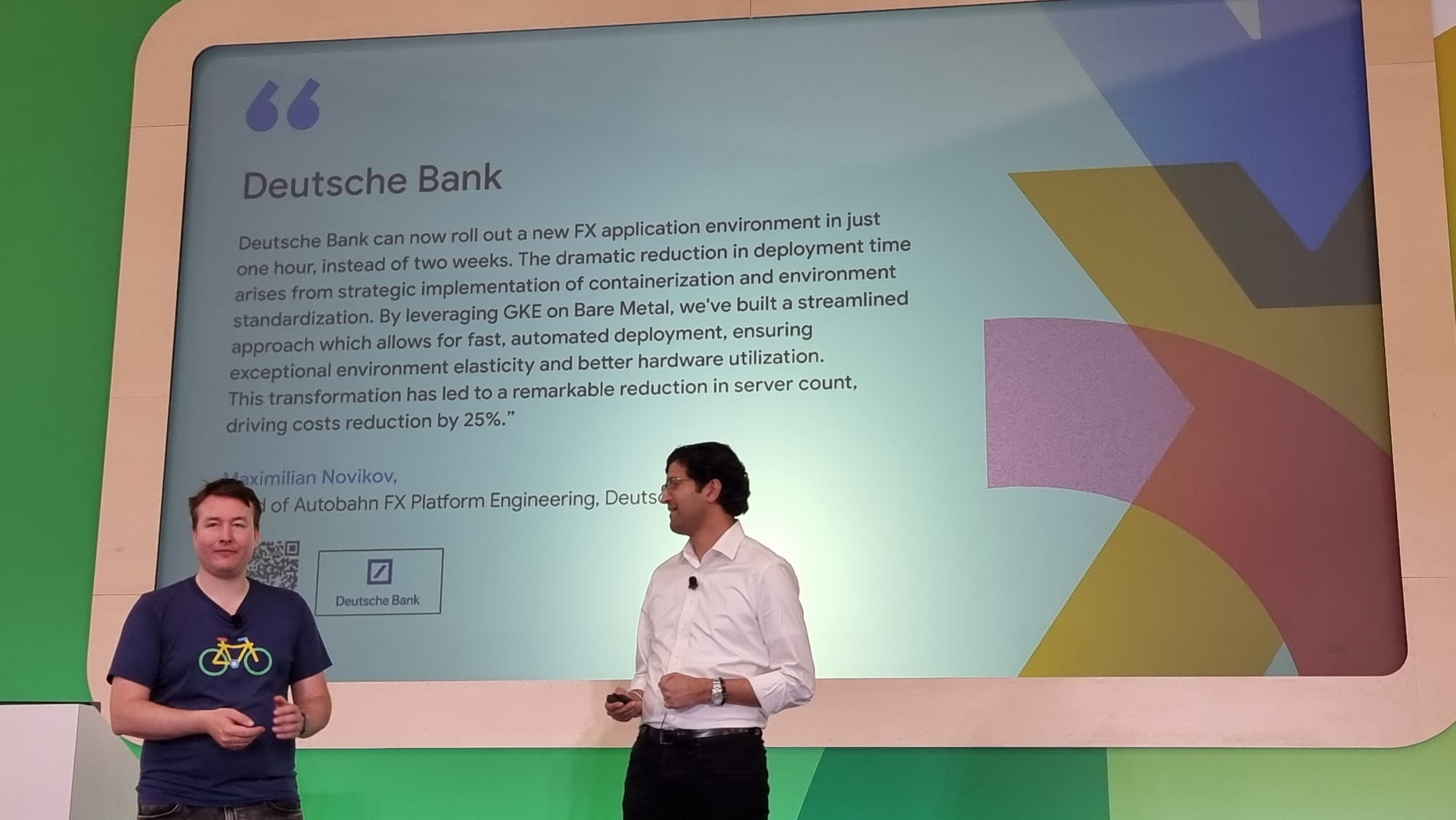

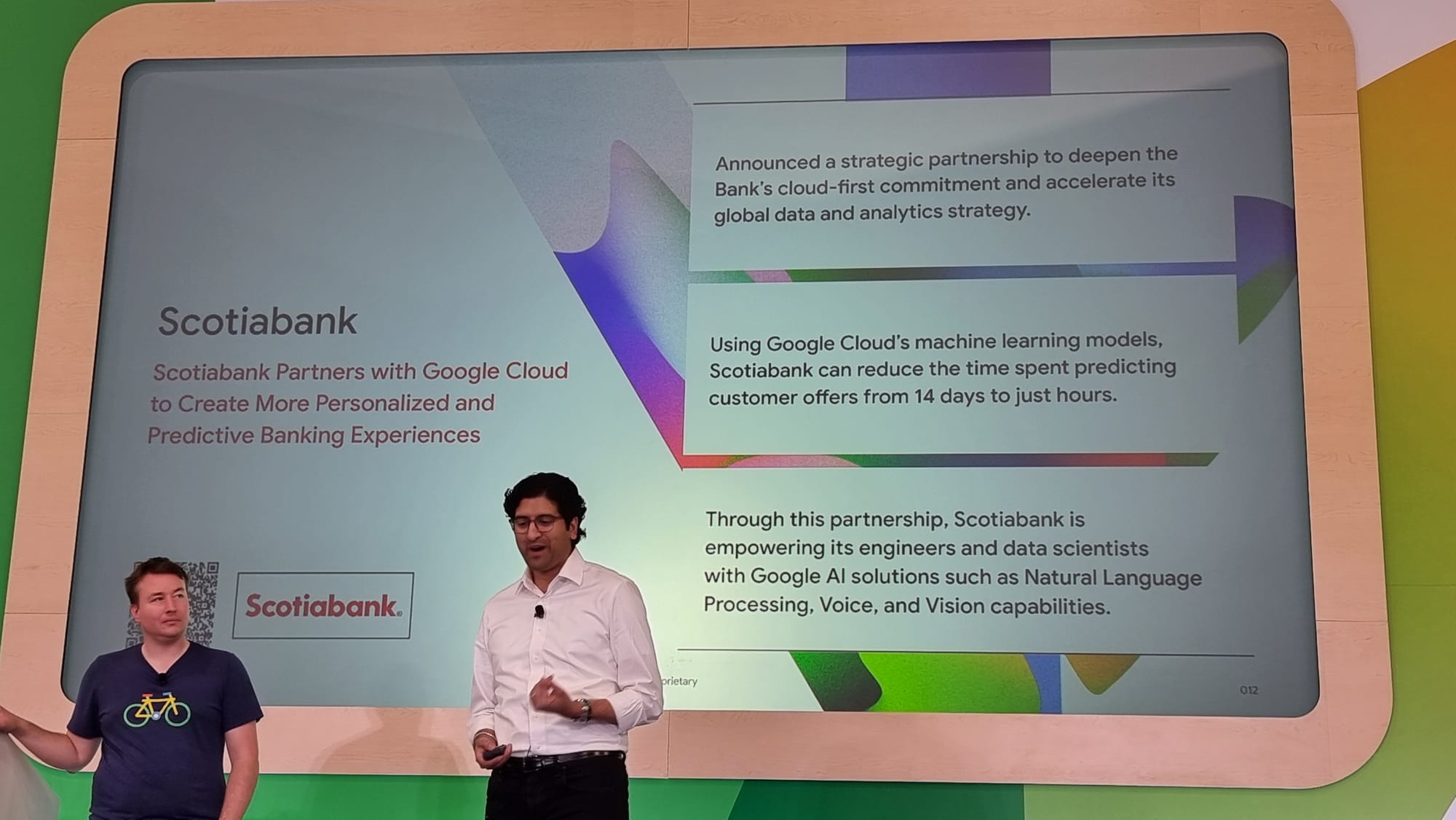

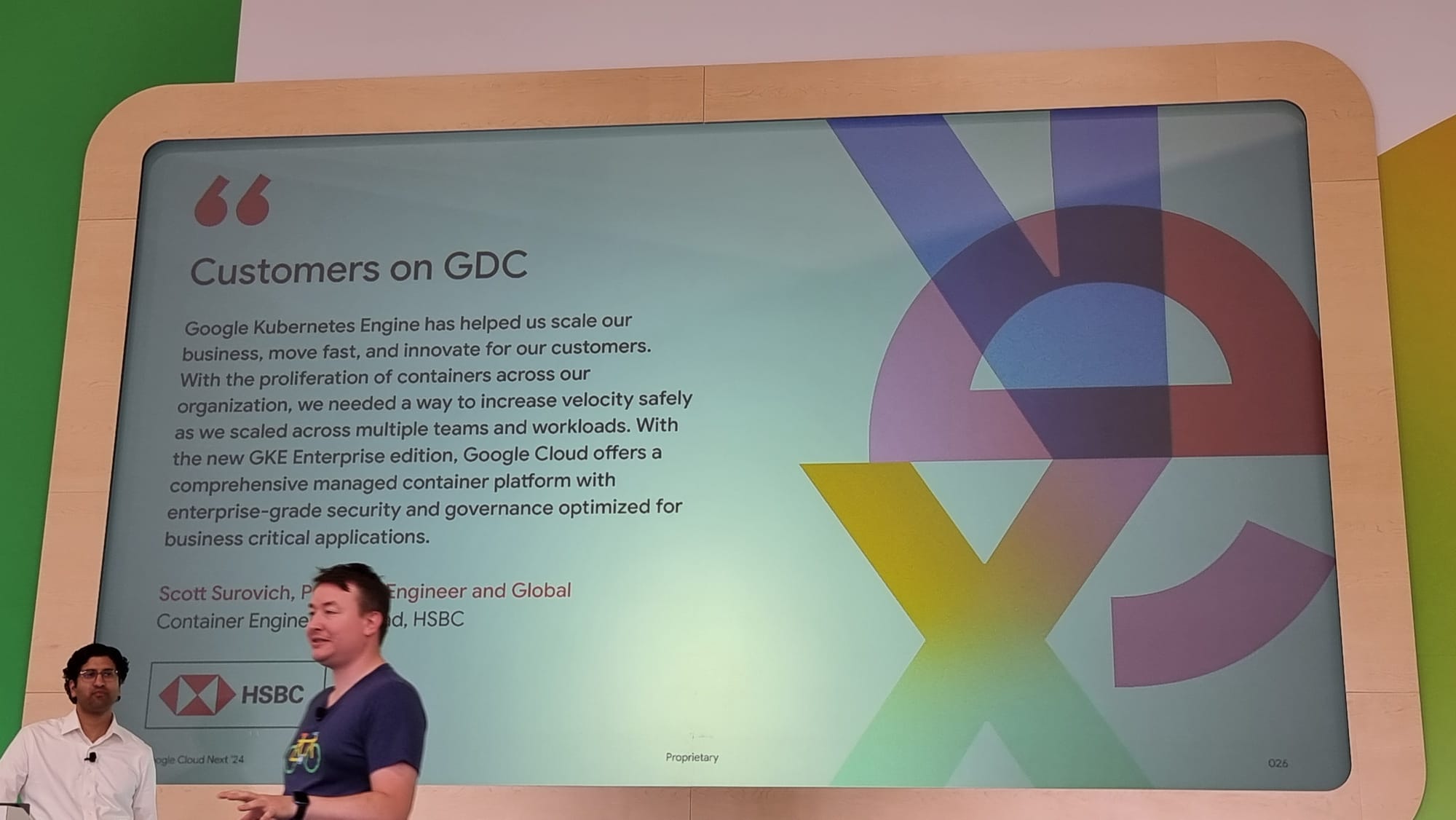

Partant des besoins de plusieurs clients (Deutsche Bank, Scotia Bank, HSBC) du milieu bancaire, un secteur notoirement connu pour ses contraintes légales et de sécurité, GKE on prem s’est vu doté des features et des améliorations suivantes :

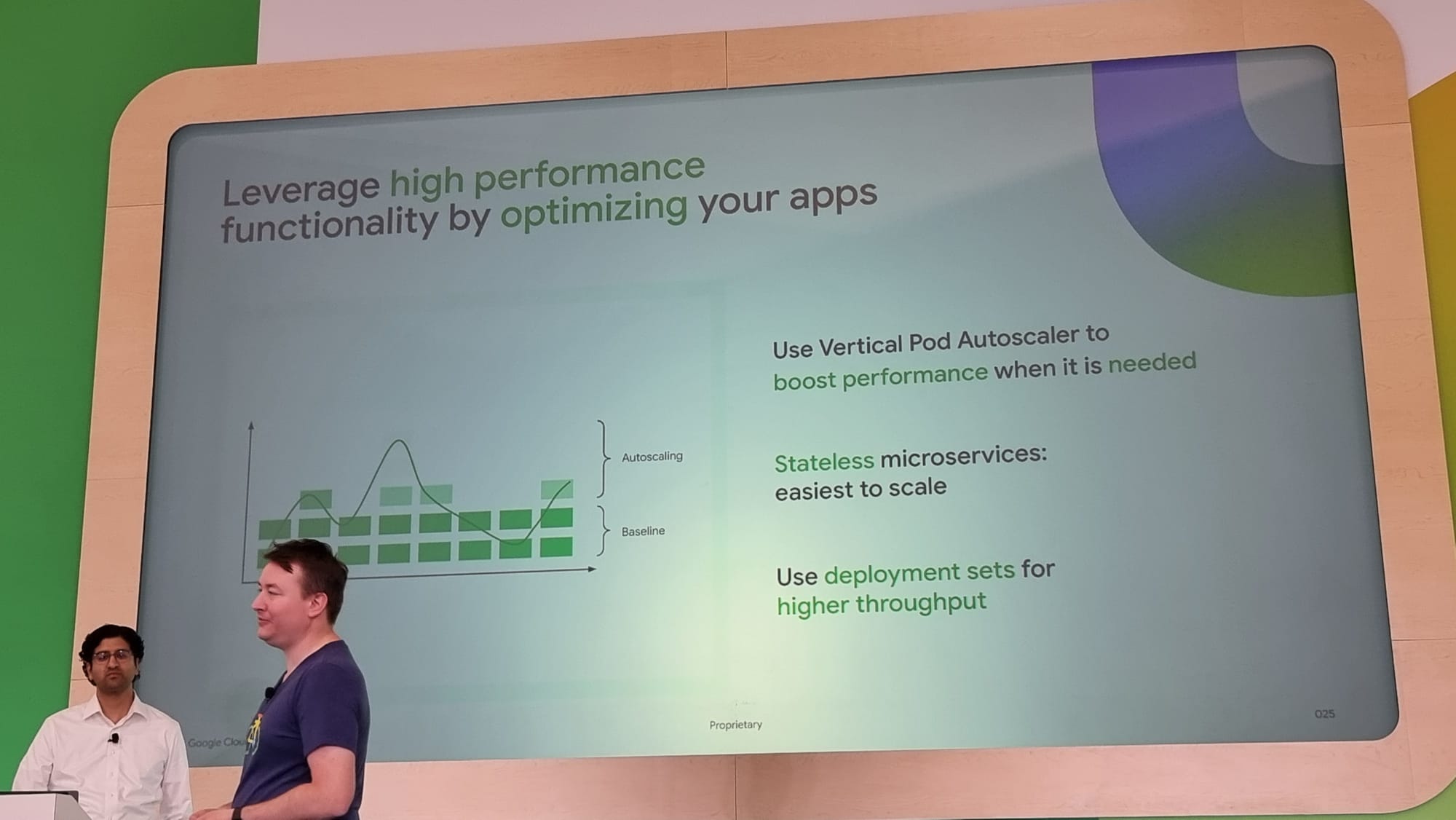

- une meilleure gestion des ressources avec le Performance Tuning Operator - CPU and Memory optimization

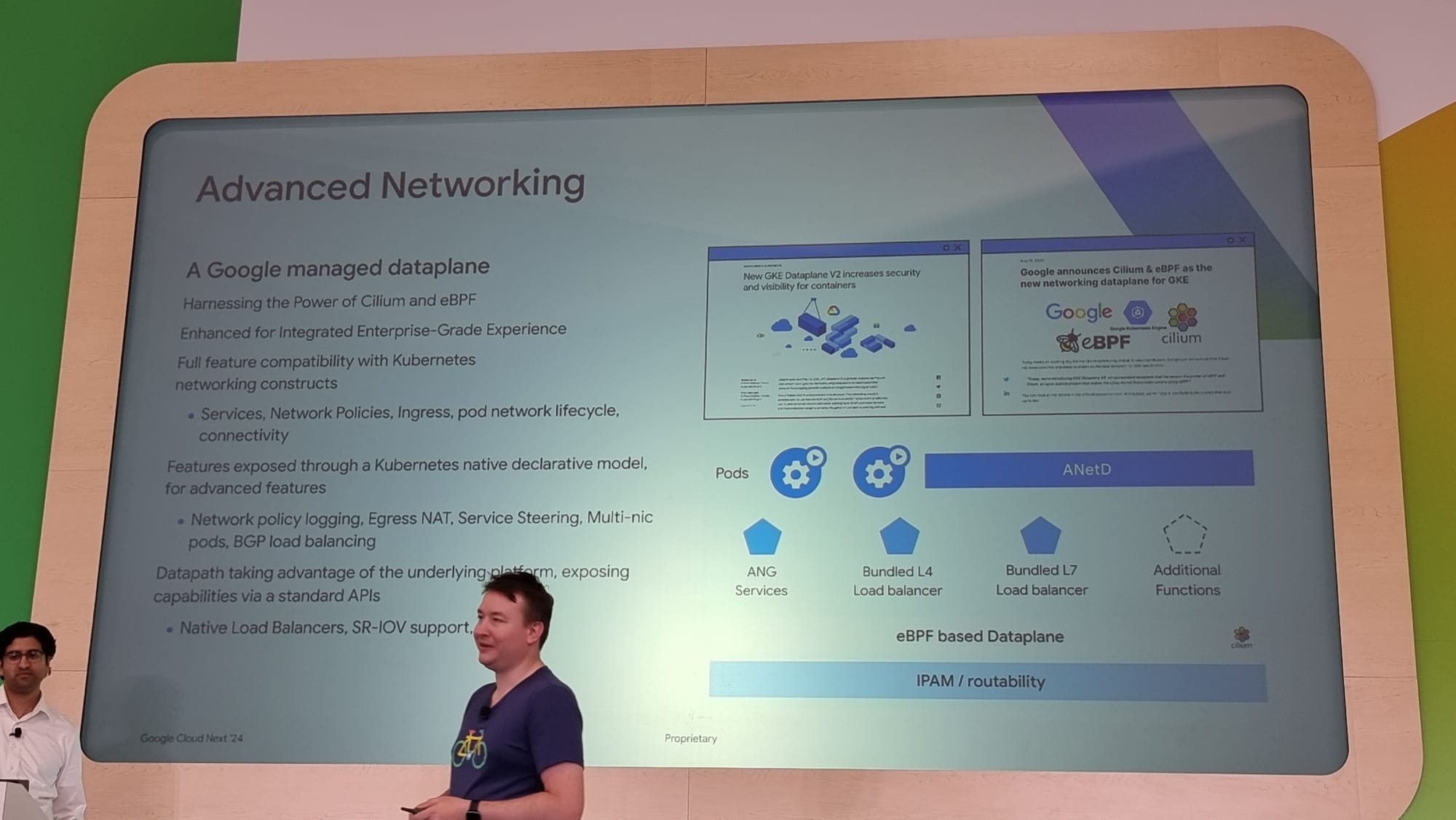

- une amélioration de la gestion du réseau avec notamment :

- le support du SR-IOV, permettant de partager les interfaces réseaux PCIe physiques entre différentes VMs

- l’intégration de Multus, permettant de disposer de plusieurs interfaces réseau par container

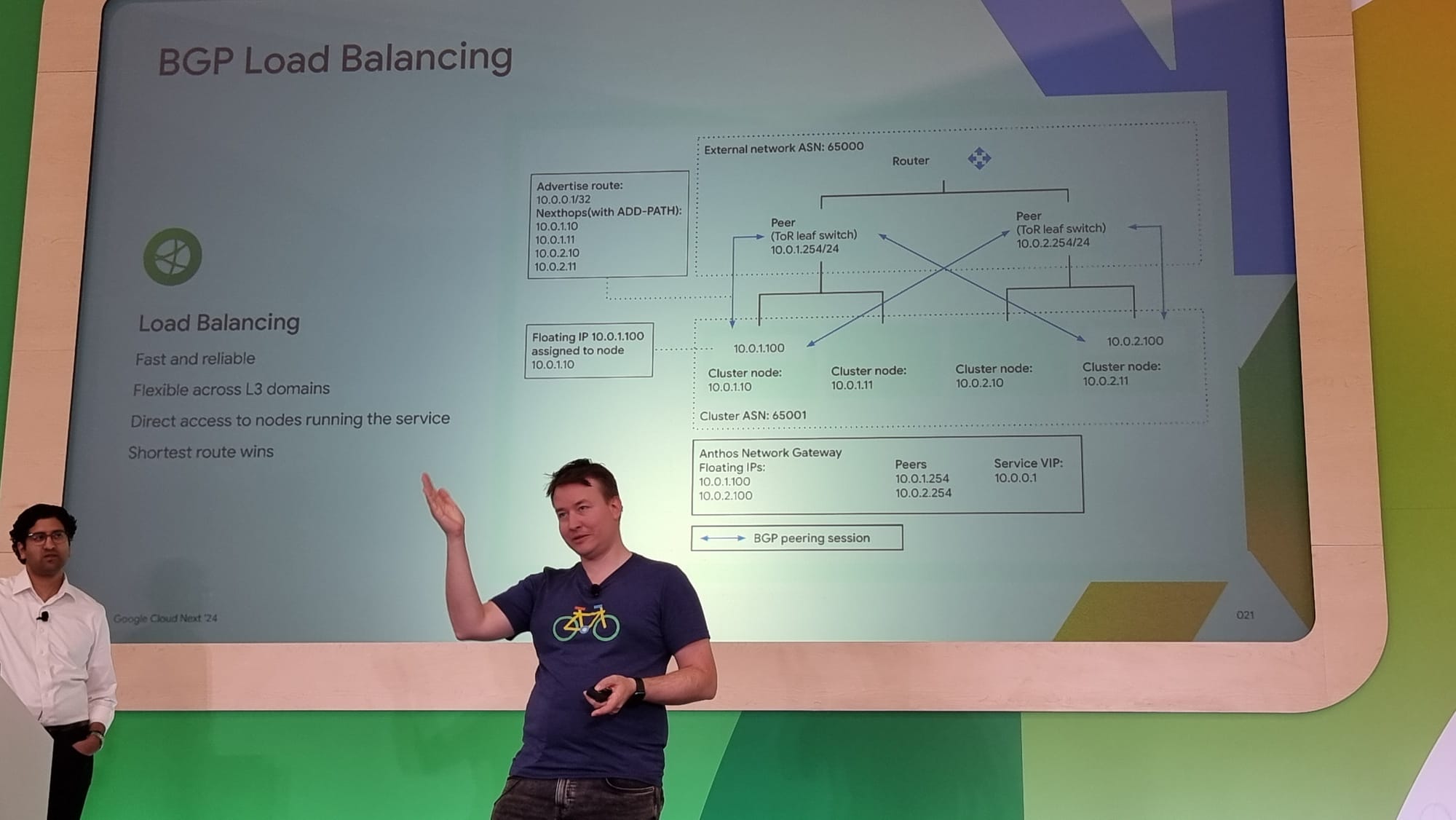

- l’apparition des BGP Load Balancers

- un accès direct aux ressources CPU et mémoire RAM

- l’utilisation de VMs jusqu’à 128 CPUs et 4TB de mémoire RAM

- le déploiement jusqu’à 30,000 pods par cluster

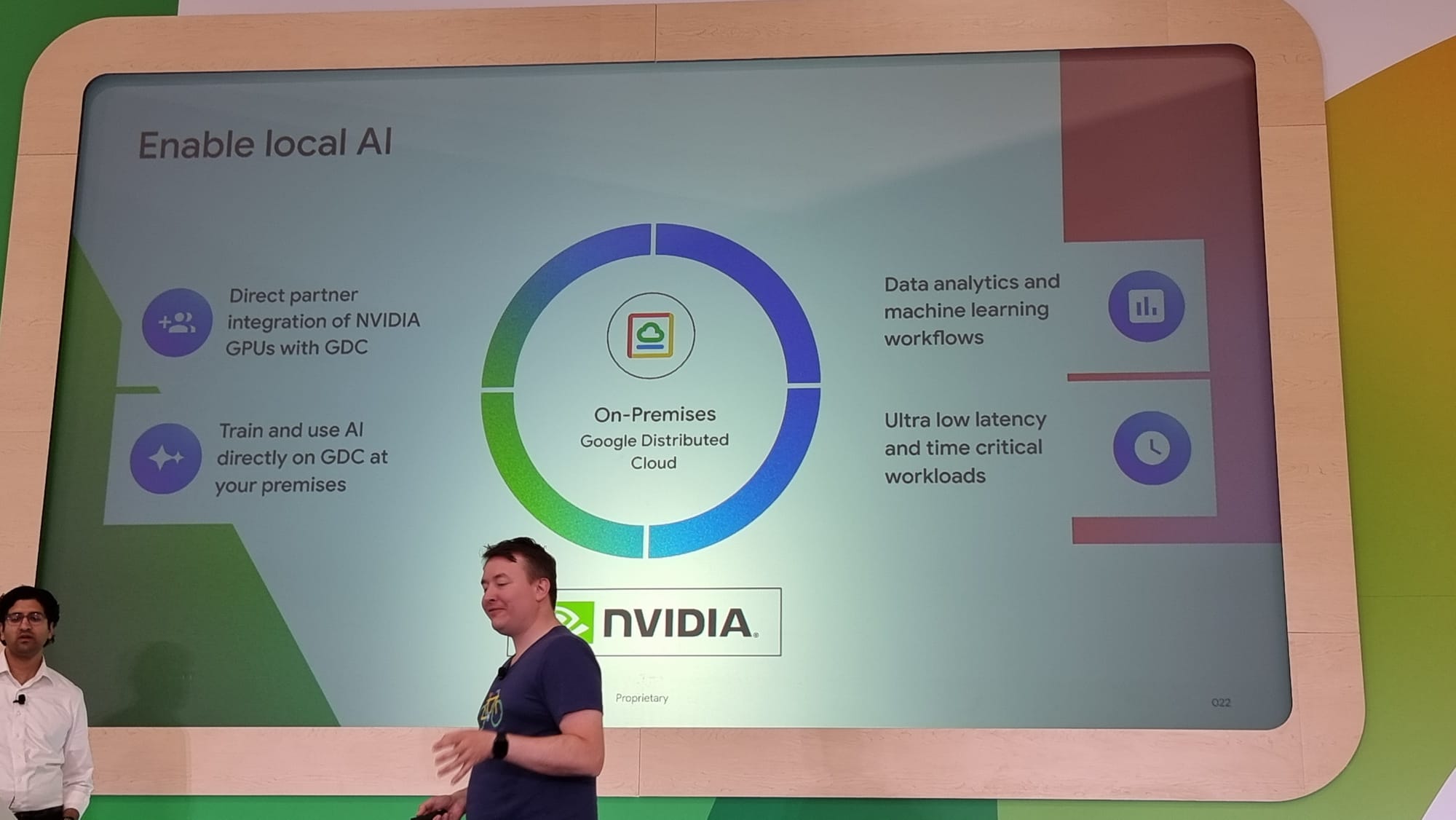

- le support des GPU NVIDIA GPU, très utile quand on cherche à entraîner des modèles de machine learning

- une amélioration du monitoring

Pour revenir sur les BGP Load Balancers, il s’agit ici de résoudre le problème du “double hop”, en dirigeant directement les paquets réseaux vers le bon pod applicatif. Ce qui permet de réduire la latence de votre application. Ce qui était avant l’apanage de GKE côté Google Cloud devient donc accessible on premise.

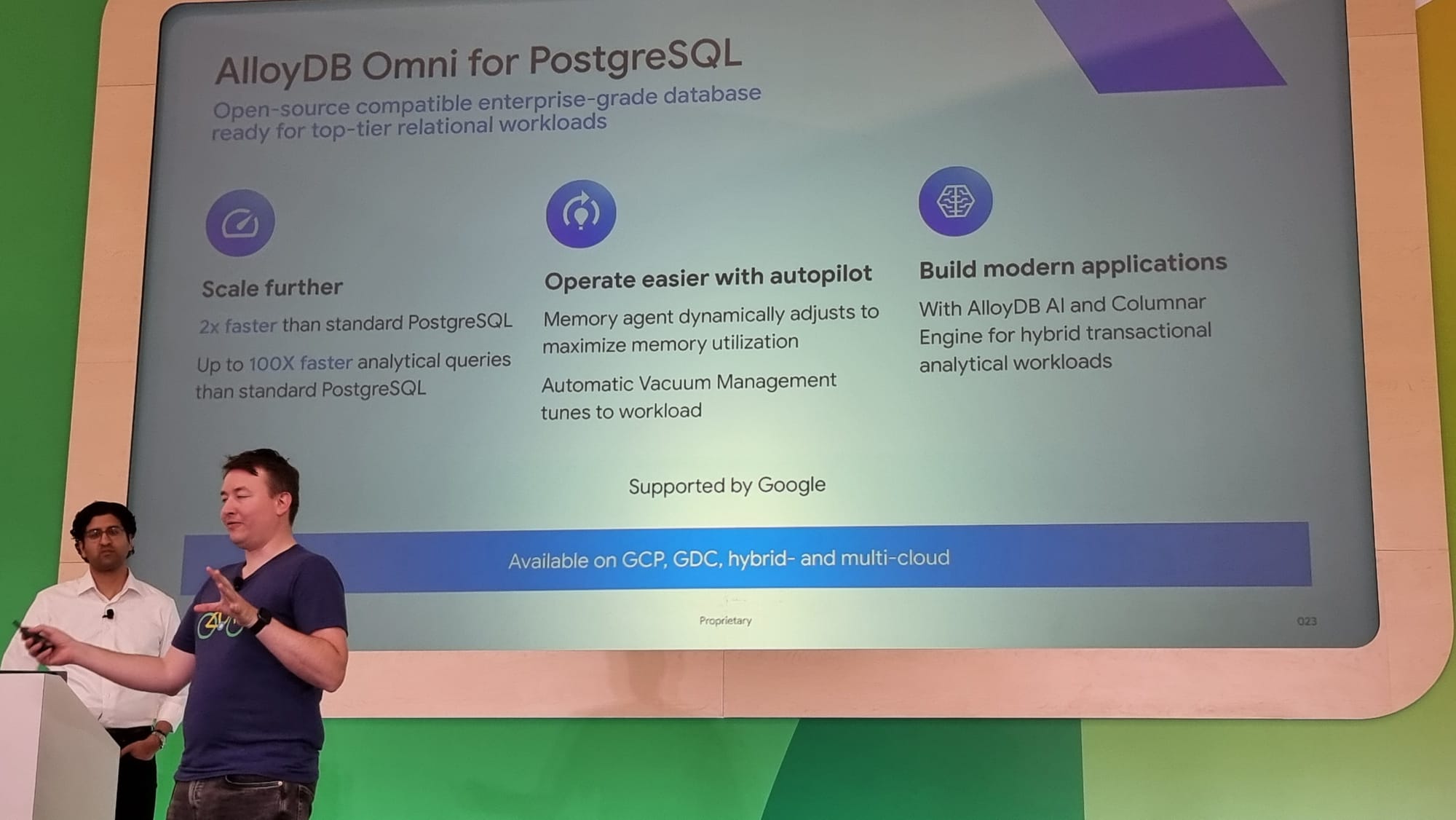

Une autre possibilité offerte par l’utilisation de GKE on prem est le déploiement de la solution “AlloyDB Omni”, un service de base de données, construit par Google à partir de PostgreSQL, avec des performances boostées.

Pour finir, quelques retours clients :

Conclusion

Ce talk n'a malheureusement pas eu pour moi l'intérêt qu'il méritait. Bien que court, il a été l'occasion de découvrir que GKE on prem n'était pas "juste" une installation managée de kubernetes, mais que, via ses features spécifiques, c'était bien plus que ça, et que Google cherchait vraiment à développer cette solution pour tirer le meilleur parti de ce qui est disponible on premise et que fondamentalement, déployer des workloads on premise n'était pas forcément un choix arbitré par des contraintes techniques ou légale, mais aussi une alternative tout à fait pertinente et qui se rapproche beaucoup des possibilités sur GCP.

Liens :

https://cloud.withgoogle.com/next/agenda?session=ARC213#day_3

![[NEXT' 24]: GenAI ou comment vivre avec son temps](/content/images/size/w1304/2024/04/8_Google_Cloud_Next_2024_JtCx8BX.max-2000x2000.jpg)

![[NEXT'24] Cloud NGFW (Next Generation Firewall)](/content/images/size/w1304/2024/04/Capture-d-e-cran-2024-04-18-a--17.57.54.png)